Gerador de Vídeo com Sincronização Labial por IA

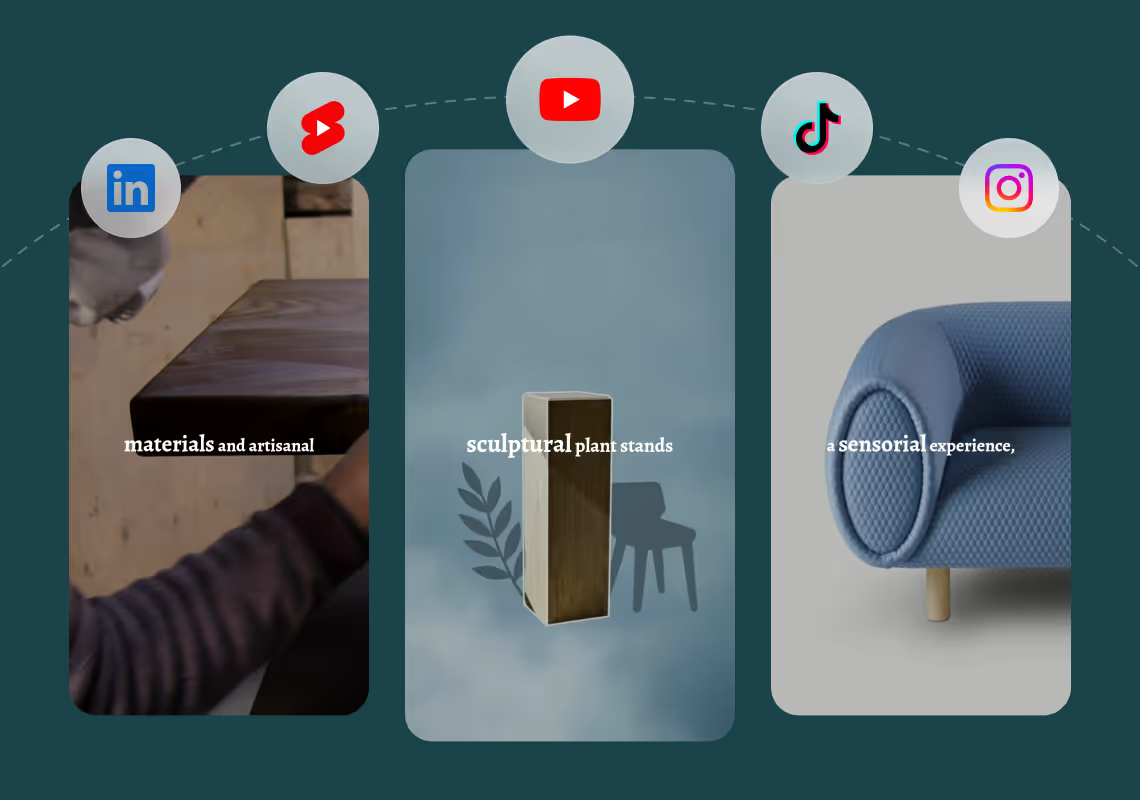

Agent Opus cria vídeos com sincronização labial por IA a partir de qualquer entrada de texto. Descreva sua mensagem, cole um roteiro ou faça upload de uma URL de blog, e obtenha um vídeo de talking-head finalizado com movimentos sincronizados da boca, voz e motion graphics. Sem sincronização manual, sem linha do tempo de edição, sem atrasos de renderização. Seu avatar de IA ou voz clonada fala suas palavras com alinhamento labial perfeito, pronto para publicar no TikTok, Instagram Reels, YouTube Shorts ou LinkedIn. Um prompt entrega um vídeo completo.

Explore what's possible with Agent Opus

Reasons why creators love Agent Opus' Gerador de Vídeo com Sincronização Labial por IA

Repurpose Content Instantly

Turn one recording into multiple versions for different platforms, audiences, or campaigns without starting from scratch.

Scale Without Burnout

Create dozens of personalized videos in the time it used to take for one, freeing you to focus on strategy and growth.

Perfect Sync Every Time

Never worry about mismatched audio again—your lips move naturally with every word, accent, and pause.

Scale Content Effortlessly

Create dozens of personalized video variations from one recording, each perfectly lip-synced to different scripts.

Fix Mistakes in Seconds

Update dialogue or correct errors without re-recording footage, saving hours of production time.

Launch-Ready in Minutes

Skip studio costs and lengthy editing sessions while delivering perfectly synced videos that look professionally produced.

How to use Agent Opus’ Gerador de Vídeo com Sincronização Labial por IA

1

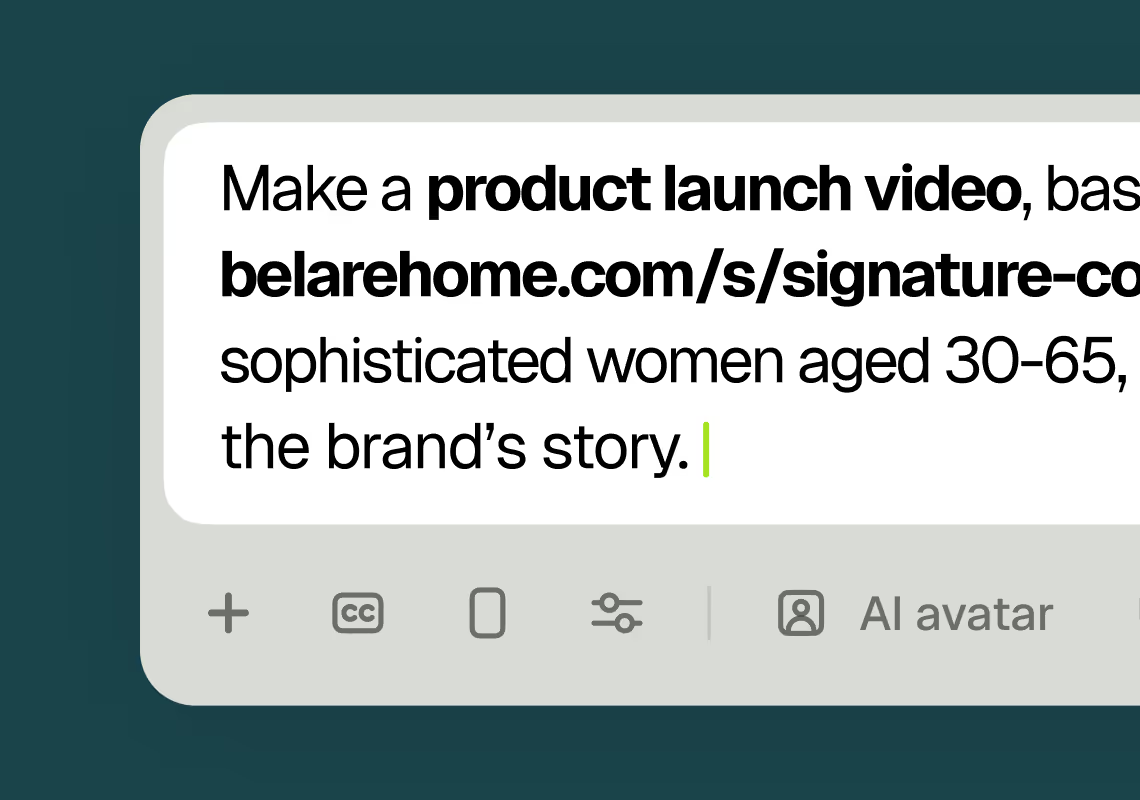

1Describe your video

Paste your promo brief, script, outline, or blog URL into Agent Opus.

2

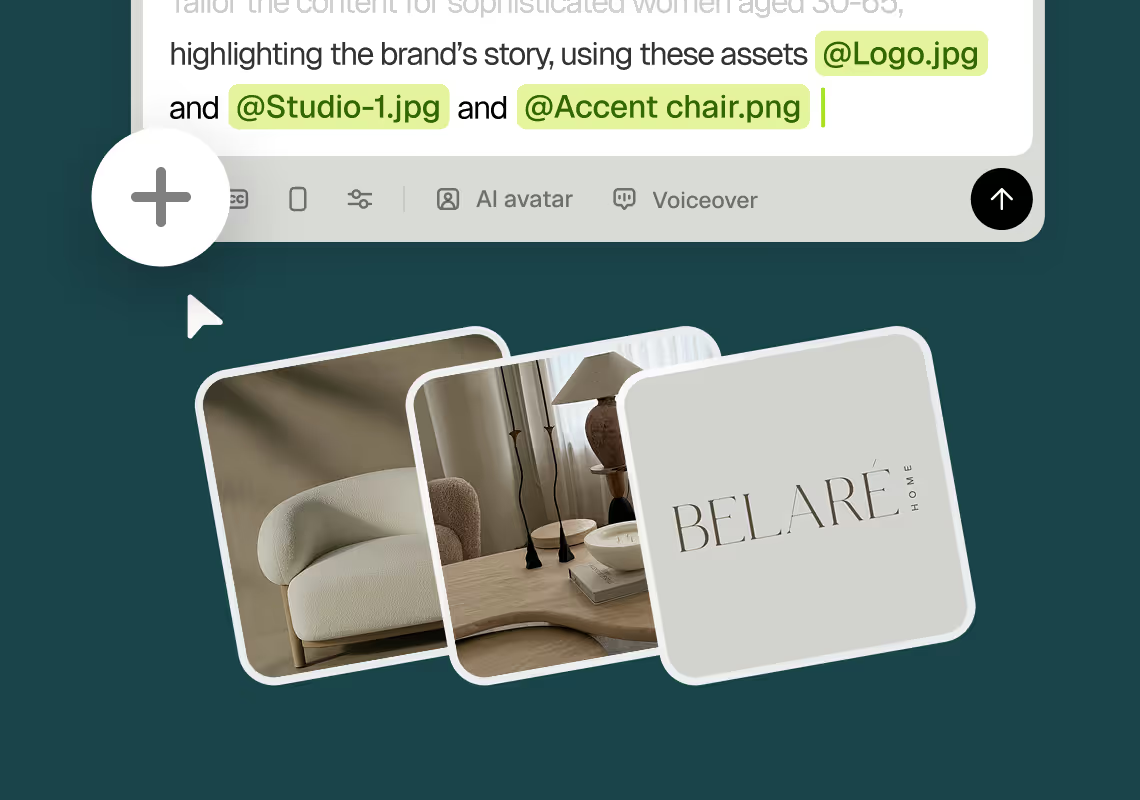

2Add assets and sources

Upload brand assets like logos and product images, or let the AI source stock visuals automatically.

3

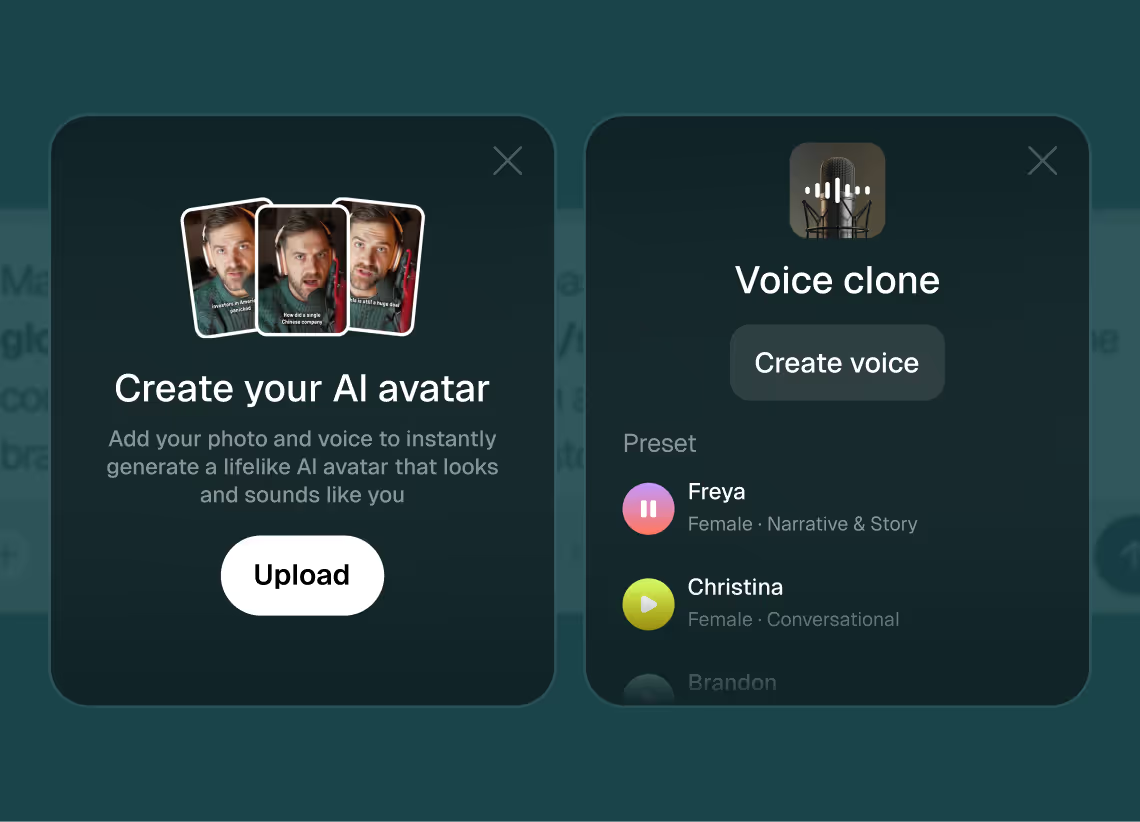

3Choose voice and avatar

Choose voice (clone yours or pick an AI voice) and avatar style (user or AI).

4

4Generate and publish-ready

Click generate and download your finished promo video in seconds, ready to publish across all platforms.

8 powerful features of Agent Opus' Gerador de Vídeo com Sincronização Labial por IA

Custom Voice Integration

Upload your own audio and watch AI avatars lip sync perfectly to your narration.

Multi-Language Sync

Create lip-synced videos in dozens of languages with accurate phoneme matching.

Realistic Lip Sync

Generate videos where avatar mouths move naturally in sync with your audio script.

Brand-Consistent Avatars

Choose or customize avatars that lip sync on-brand messaging across all your videos.

Testimonials

Awesome output, Most of my students and followers could not catch that it was using Agent Opus. Thank you Opus.

Wealth with Gaurav

This looks like a game-changer for us. We're building narrative-driven, visually layered content — and the ability to maintain character and motion consistency across episodes would be huge. If Agent Opus can sync branded motion graphics, tone, and avatar style seamlessly, it could easily become part of our production stack for short-form explainers and long-form investigative visuals.

srtaduck

I reviewed version a and I was very impressed with this version, it did very well in almost all aspects that users need, you would only have to make very small changes and maybe replace one of 2 of the pictures, but even saying that it could be used as is and still receive decent views or even chances at going viral depending on the story or the content the user chooses.

Jeremy

all in all LOVE THIS agent. I'm curious to see how I can push it (within reason) Just need to learn to get the consistency right with my prompts

Rebecca

Frequently Asked Questions

Como o vídeo com sincronização labial por IA lida com diferentes estilos de voz e sotaques?

Agent Opus analisa a estrutura fonética do seu áudio independentemente do sotaque, velocidade de fala ou tom vocal. Quando você clona sua voz ou seleciona uma voz de IA, o sistema mapeia cada fonema (a menor unidade de som da fala) para uma forma correspondente da boca, ou visema. Esse mapeamento de fonema para visema funciona em diferentes idiomas e sotaques porque opera no nível do som, não no nível da palavra. Se você fala com um sotaque regional, a IA detecta os sons reais que você produz e sincroniza a boca do avatar para corresponder a essas pronúncias exatas. Para falantes rápidos, o sistema ajusta o tempo de cada forma da boca para acompanhar as sílabas rápidas. Para uma entrega lenta e deliberada, ele estende a duração de cada visema para que os lábios nunca pareçam atrasar ou adiantar em relação ao áudio. O resultado é uma sincronização labial natural que respeita suas características vocais únicas. Você pode testar isso gerando vídeos com diferentes clones de voz ou vozes de IA e comparando o movimento da boca. Cada um sincronizará com precisão porque a análise fonética subjacente se adapta à entrada de áudio, não a um modelo genérico.

Quais são as melhores práticas para escrever roteiros que produzem o vídeo com sincronização labial por IA mais natural?

A sincronização labial natural começa com roteiros conversacionais que correspondem a como as pessoas realmente falam. Evite frases longas e complexas com múltiplas orações, porque elas forçam o avatar a manter formas da boca por períodos prolongados sem pausas naturais. Em vez disso, escreva frases curtas com estrutura clara de sujeito-verbo-objeto. Use contrações como "você está" e "é" em vez de formas expandidas, porque as contrações refletem padrões de fala reais e produzem transições mais suaves da boca. Inclua pausas naturais adicionando vírgulas ou dividindo pensamentos em frases separadas. Isso dá à IA pistas para fechar a boca brevemente, imitando como os humanos pausam para respirar ou enfatizar um ponto. Evite jargões técnicos ou palavras inventadas, a menos que você possa soletrá-las foneticamente, porque a IA pode pronunciar incorretamente termos desconhecidos e criar movimento labial incompatível. Se seu roteiro incluir números, escreva-os por extenso ("vinte e três" em vez de "23") para que o gerador de voz os pronuncie corretamente e a sincronização labial acompanhe. Teste seu roteiro lendo-o em voz alta antes de gerar o vídeo. Se soar rígido ou artificial quando você o fala, o avatar também parecerá rígido. Agent Opus funciona melhor com roteiros que soam como uma pessoa real conversando com um amigo, não lendo de um teleprompter.

O vídeo com sincronização labial por IA pode manter a marca consistente em vários vídeos com roteiros diferentes?

Sim, Agent Opus permite que você faça upload de recursos da marca como logotipos, imagens de produtos e paletas de cores que persistem em todos os seus projetos de vídeo com sincronização labial por IA. Quando você gera um novo vídeo, o sistema extrai da sua biblioteca de recursos para enquadrar o avatar com elementos visuais consistentes. Por exemplo, você pode definir um gráfico padrão de lower-third com seu logotipo e slogan que aparece em todos os vídeos, ou definir um modelo de fundo que usa as cores da sua marca e fotos de produtos. O próprio avatar também pode ser consistente. Se você fizer upload de uma foto sua ou de um membro da equipe, Agent Opus gera uma versão digital desse rosto e a usa para cada vídeo que você criar. Combine isso com uma voz clonada, e cada vídeo apresenta o mesmo locutor com a mesma identidade visual e vocal. Essa consistência é importante para construir reconhecimento do público. Os espectadores veem o mesmo rosto e ouvem a mesma voz em seu conteúdo do TikTok, LinkedIn e YouTube, reforçando sua marca mesmo quando o roteiro muda. Você também pode criar múltiplos pares de avatar-voz para diferentes tipos de conteúdo. Por exemplo, use um avatar para demonstrações de produtos e outro para depoimentos de clientes, cada um com sua própria voz clonada e modelo de fundo. Agent Opus salva essas configurações para que você possa alternar entre elas sem fazer novo upload de recursos ou ajustar configurações.

Quais são as limitações ou casos extremos da geração de vídeo com sincronização labial por IA?

O vídeo com sincronização labial por IA funciona melhor com fala clara e conversacional em idiomas amplamente falados. Casos extremos incluem roteiros com ruído de fundo pesado no clone de voz, efeitos vocais extremos como sussurrar ou gritar, ou idiomas com conjuntos de fonemas não bem representados nos dados de treinamento. Se você clonar sua voz de uma gravação com música ou som ambiente, a IA pode ter dificuldade em isolar os fonemas da fala, levando a uma sincronização labial menos precisa. Para evitar isso, grave seu clone de voz em um ambiente silencioso com um microfone decente. Estilos vocais extremos também desafiam o sistema. Sussurrar reduz a energia acústica de certos fonemas, tornando mais difícil para a IA detectar transições de forma da boca. Gritar ou cantar introduz variações de tom que podem confundir o mapeamento de fonema para visema. Para melhores resultados, use uma voz de fala natural em volume moderado. Outro caso extremo é a alternância rápida de código entre idiomas dentro de um único roteiro. Se seu roteiro alterna entre português e inglês no meio da frase, a IA pode não fazer a transição das formas da boca suavemente porque cada idioma tem regras de fonemas diferentes. Mantenha um idioma por vídeo, ou separe conteúdo multilíngue em clipes distintos. Finalmente, roteiros muito longos (mais de 10 minutos de fala) podem produzir vídeos onde a expressão do avatar se torna estática ao longo do tempo. Agent Opus gera microexpressões e movimentos de cabeça para manter o avatar realista, mas monólogos prolongados podem parecer menos dinâmicos do que vídeos mais curtos e impactantes. Divida conteúdo longo em vários vídeos para manter o interesse visual e dar à IA mais oportunidades de variar a performance do avatar.