KI-Synchronisations-Videoersteller

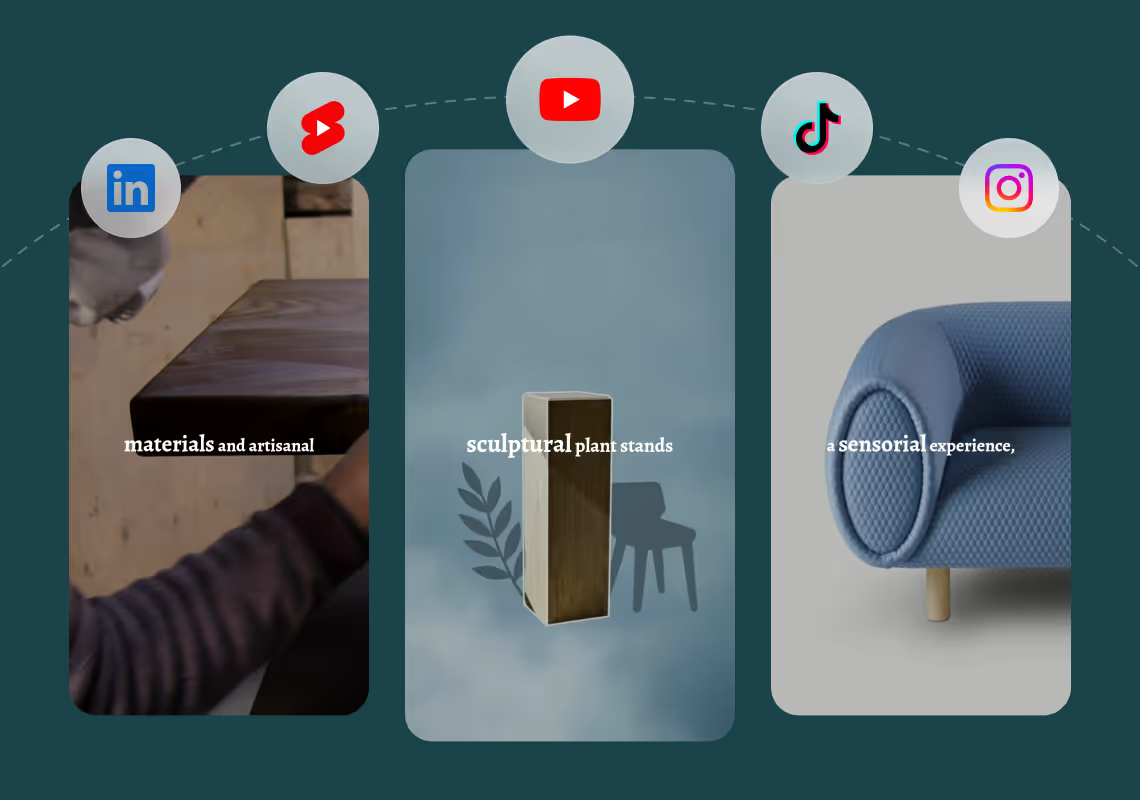

Generieren Sie professionelle synchronisierte Videos aus Text in wenigen Minuten. Agent Opus ist ein KI-Synchronisations-Videoersteller, der Skripte, Prompts oder Blogbeiträge in vollständige Videos mit geklonten Stimmen, KI-Avataren und dynamischen Motion Graphics verwandelt. Kein Aufnahmestudio, keine Synchronsprecher, keine manuelle Bearbeitung. Beschreiben Sie Ihr Video, wählen Sie Ihre Stimme und Sprache und veröffentlichen Sie sofort auf TikTok, YouTube, LinkedIn oder überall dort, wo Ihr Publikum ist.

Explore what's possible with Agent Opus

Reasons why creators love Agent Opus' KI-Synchronisations-Videoersteller

Consistent Brand Sound

Maintain the same vocal identity and messaging quality in every language so your brand feels cohesive no matter where viewers watch.

Global Reach Overnight

Turn one video into dozens of language versions so your content connects with audiences worldwide without reshoots or studio time.

Launch-Ready in Minutes

Skip weeks of translation coordination and post-production so you can publish multilingual content while ideas are still fresh and trending.

Budget-Friendly Expansion

Eliminate costly voice actors and localization teams so you can scale internationally without burning through your production budget.

Your Voice, Every Language

Keep your authentic tone and personality intact across all dubbed versions so viewers feel like you're speaking directly to them.

Effortless Workflow Integration

Generate dubbed versions without learning complex software or managing multiple vendors so you stay focused on creating great content.

How to use Agent Opus’ KI-Synchronisations-Videoersteller

1

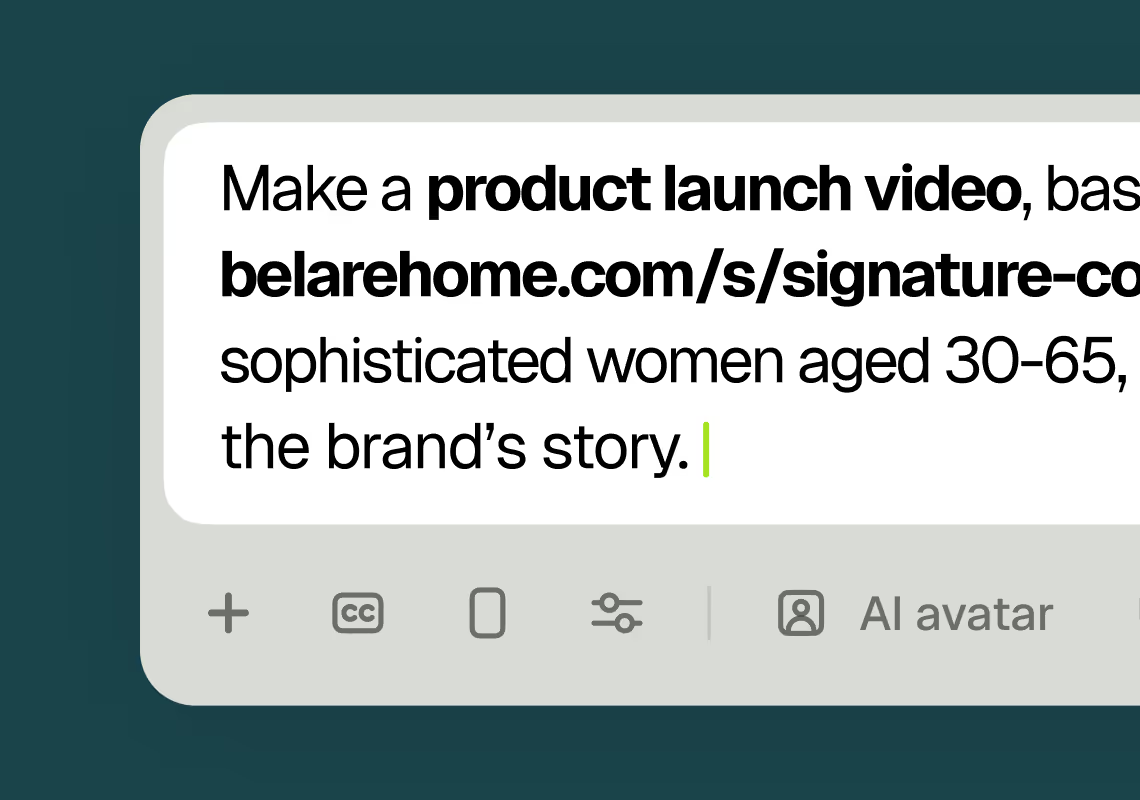

1Describe your video

Paste your promo brief, script, outline, or blog URL into Agent Opus.

2

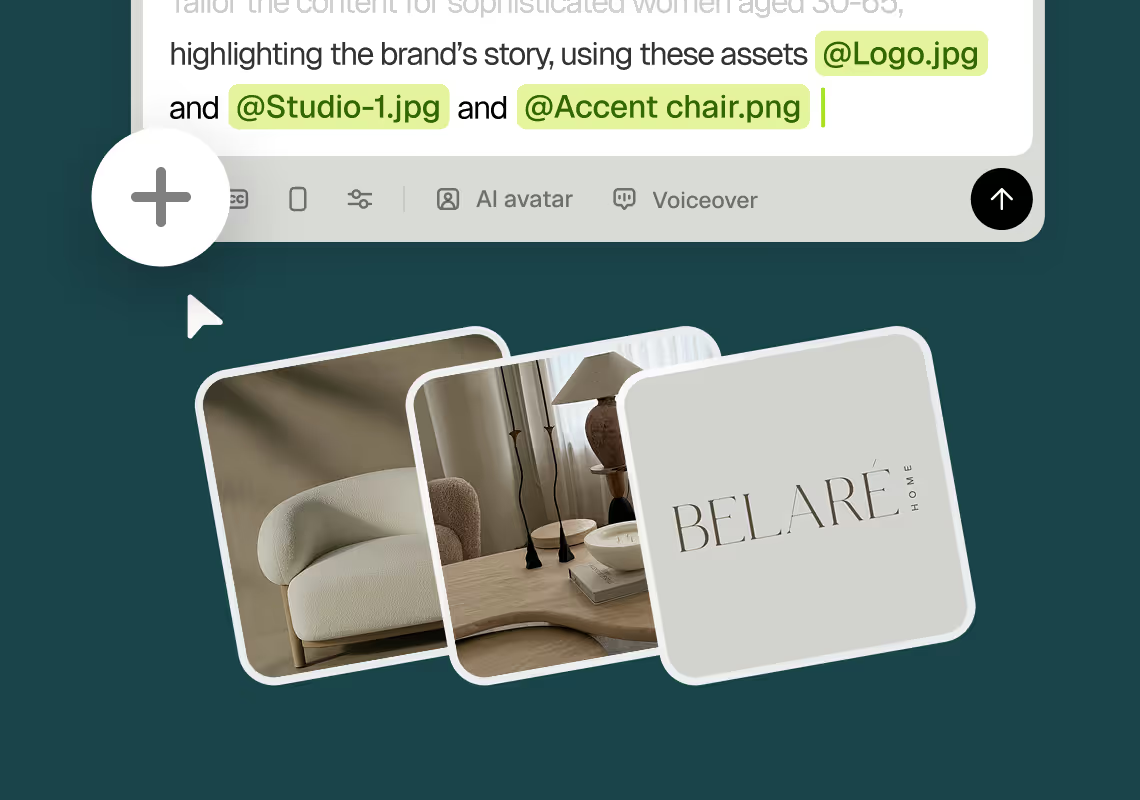

2Add assets and sources

Upload brand assets like logos and product images, or let the AI source stock visuals automatically.

3

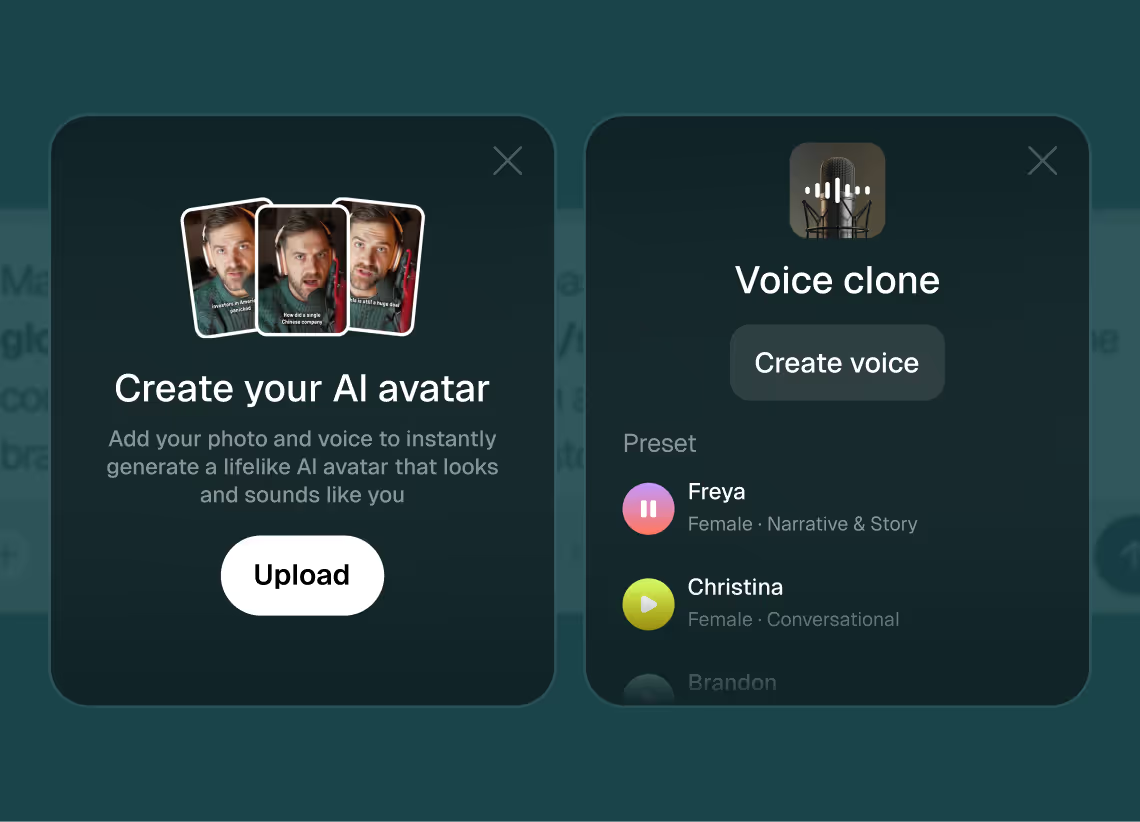

3Choose voice and avatar

Choose voice (clone yours or pick an AI voice) and avatar style (user or AI).

4

4Generate and publish-ready

Click generate and download your finished promo video in seconds, ready to publish across all platforms.

8 powerful features of Agent Opus' KI-Synchronisations-Videoersteller

Lip-Sync Accuracy

Match dubbed voiceovers to on-screen speaker movements for natural, believable multilingual videos.

Preserve Brand Voice

Maintain consistent tone, pacing, and personality across all dubbed language versions of your content.

Batch Dubbing Generation

Create multiple language versions of the same video simultaneously to accelerate global content rollout.

Voice Cloning for Dubbing

Clone your original speaker's voice and apply it across translated audio tracks automatically.

Automated Timing Alignment

AI adjusts dubbed speech length and pauses to match original video pacing without manual editing.

High-Fidelity Audio Output

Produce studio-quality dubbed voiceovers that sound natural and professional in every target language.

Instant Translation Workflow

Upload your video script or audio and receive dubbed versions in target languages within minutes.

Multi-Language Voice Dubbing

Generate videos with AI-dubbed audio in dozens of languages while preserving original tone and emotion.

Testimonials

Awesome output, Most of my students and followers could not catch that it was using Agent Opus. Thank you Opus.

Wealth with Gaurav

This looks like a game-changer for us. We're building narrative-driven, visually layered content — and the ability to maintain character and motion consistency across episodes would be huge. If Agent Opus can sync branded motion graphics, tone, and avatar style seamlessly, it could easily become part of our production stack for short-form explainers and long-form investigative visuals.

srtaduck

wow that's actually great 🔥

irtaza65

Frequently Asked Questions

Wie funktioniert das Stimmenklonen beim KI-Synchronisations-Videoersteller über verschiedene Sprachen hinweg?

Agent Opus verwendet fortschrittliche Stimmenklonungs-Technologie, um die einzigartigen Eigenschaften Ihrer Stimme zu erfassen – einschließlich Tonfall, Tonhöhe, Rhythmus und Sprechstil – und wendet diese Eigenschaften dann auf synchronisiertes Audio in Ihren Zielsprachen an. Wenn Sie eine Stimmprobe bereitstellen oder direkt auf der Plattform aufnehmen, analysiert die KI Hunderte von Stimmmerkmalen, um ein Stimmmodell zu erstellen. Dieses Modell kann dann Sprache in mehreren Sprachen generieren und dabei Ihre wiedererkennbare Stimmsignatur beibehalten. Der Prozess funktioniert anders als einfache Übersetzung und Text-to-Speech. Agent Opus übersetzt nicht einfach Wörter und liest sie mit einer generischen Stimme vor. Stattdessen bewahrt es die emotionalen Nuancen, das Tempo und die Persönlichkeit des ursprünglichen Sprechers über Sprachgrenzen hinweg. Wenn Ihre englische Stimme beispielsweise einen warmen, gesprächigen Ton mit leichten Pausen zur Betonung hat, wird die spanische oder französische synchronisierte Version dieselben Qualitäten aufweisen. Dies schafft eine konsistente Markenstimme über alle Ihre internationalen Inhalte hinweg. Die KI bewältigt auch phonetische Herausforderungen automatisch. Verschiedene Sprachen haben unterschiedliche Klangmuster, Mundformen und Rhythmusstrukturen. Agent Opus passt das synchronisierte Audio an, damit es in jeder Zielsprache natürlich klingt, während Ihre grundlegende Stimmidentität erhalten bleibt. Sie können synchronisierte Videos in Sprachen generieren, die Sie nicht fließend sprechen, und das Ergebnis klingt wie ein Muttersprachler mit Ihren Stimmeigenschaften. Für Creator und Marketer, die in globale Märkte expandieren, bedeutet dies, dass Sie eine persönliche Verbindung zu internationalen Zielgruppen aufrechterhalten können, ohne für jede Sprache Synchronsprecher engagieren oder mehrere Sprachen selbst lernen zu müssen. Das Stimmenklonen funktioniert mit kurzen Proben – typischerweise nur wenige Minuten klares Audio – und verbessert sich, je mehr Inhalte Sie generieren. Agent Opus bietet auch eine Bibliothek professioneller KI-Stimmen, falls Sie Ihre eigene Stimme nicht klonen möchten, mit Optionen für verschiedene Altersgruppen, Geschlechter, Akzente und Sprechstile in Dutzenden von Sprachen.

Was sind Best Practices für Skripte bei der Verwendung des KI-Synchronisations-Videoerstellers für mehrere Sprachen?

Das Schreiben von Skripten für den KI-Synchronisations-Videoersteller erfordert ein Verständnis dafür, wie Sprachstruktur und kultureller Kontext das Videotempo und die visuelle Synchronisation beeinflussen. Beginnen Sie mit klarer, gesprächiger Sprache in Ihrem Ausgangsskript. Vermeiden Sie Redewendungen, Slang oder kulturspezifische Bezüge, die sich nicht gut übersetzen lassen. Ausdrücke wie „den Ball aus dem Park schlagen" oder „ein Kinderspiel" können internationale Zielgruppen verwirren oder erfordern umständliche Umschreibungen in synchronisierten Versionen. Verwenden Sie stattdessen direkte Sprache, die Ihre Bedeutung wörtlich vermittelt. Sagen Sie zum Beispiel „hervorragende Ergebnisse erzielen" anstatt „es aus dem Park schlagen". Halten Sie Sätze relativ kurz und konzentrieren Sie sich auf jeweils eine Idee. Lange, komplexe Sätze mit mehreren Nebensätzen können bei der Übersetzung verworren werden und machen synchronisiertes Audio schwerer mit Bildern zu synchronisieren. Streben Sie nach Möglichkeit Sätze unter 20 Wörtern an. Dies hilft Zuschauern auch, Informationen leichter zu verarbeiten, besonders wenn sie in einer Fremdsprache schauen. Berücksichtigen Sie Textexpansion und -kontraktion über Sprachen hinweg. Manche Sprachen benötigen mehr Wörter oder Silben, um dieselbe Idee auszudrücken. Deutsch und Finnisch sind oft länger als Englisch, während Chinesisch und Japanisch kompakter sein können. Agent Opus passt das Tempo automatisch an, aber Sie können helfen, indem Sie natürliche Pausen in Ihr Skript einbauen und durchgehende Erzählung vermeiden. Bauen Sie visuelle Momente ein, in denen kein Voiceover benötigt wird, damit die KI Raum hat, das Timing über Sprachversionen hinweg anzupassen, ohne gehetzt oder schleppend zu wirken. Verwenden Sie Aktivsätze und starke Verben. Passivkonstruktionen und schwache Verben übersetzen sich schlecht und klingen in vielen Sprachen unnatürlich. „Wir haben diese Funktion entwickelt" ist klarer und direkter als „Diese Funktion wurde von uns entwickelt." Aktivsätze erzeugen auch ansprechenderes synchronisiertes Audio mit besserem Rhythmus und mehr Energie. Fügen Sie Aussprachehinweise für Markennamen, Produktnamen oder Fachbegriffe hinzu, die in allen Sprachen konsistent klingen sollten. Agent Opus kann bestimmte Aussprachen beibehalten, wenn Sie diese markieren, um sicherzustellen, dass Ihre Markenidentität in jeder synchronisierten Version intakt bleibt. Testen Sie Ihr Skript, indem Sie es laut vorlesen, bevor Sie synchronisierte Videos generieren. Wenn es sich beim Sprechen unnatürlich oder holprig anhört, wird es in synchronisierter Form noch schlechter klingen. Gesprächige, sprechbare Sprache funktioniert immer am besten für KI-Synchronisations-Videoersteller-Anwendungen.

Kann der KI-Synchronisations-Videoersteller Markenkonsistenz über verschiedene Sprachversionen hinweg aufrechterhalten?

Agent Opus ist speziell darauf ausgelegt, Markenkonsistenz bei der Generierung synchronisierter Videos über mehrere Sprachen hinweg aufrechtzuerhalten. Die Plattform behandelt Ihre Marken-Assets, Ihren visuellen Stil und Ihre Botschaften als Kernelemente, die konstant bleiben, während sich nur die Sprache und das synchronisierte Audio ändern. Wenn Sie ein synchronisiertes Videoprojekt erstellen, können Sie Ihr Logo, Markenfarben, Produktbilder und andere visuelle Assets einmal hochladen, und Agent Opus wendet sie konsistent auf alle Sprachversionen an. Das bedeutet, ein Zuschauer in Spanien sieht dieselbe Logo-Platzierung, dasselbe Farbschema und dieselben Produktaufnahmen wie ein Zuschauer in Japan – nur das synchronisierte Voiceover und eventuelle Bildschirmtexte werden an ihre Sprache angepasst. Das KI-Motion-Graphics-System behält denselben visuellen Rhythmus und Stil über Sprachen hinweg bei, auch wenn das Timing des synchronisierten Audios leicht variiert. Wenn Ihre englische Version eine dynamische Produktenthüllung bei der 15-Sekunden-Marke hat, werden die französische und deutsche Version dieselbe Enthüllung zeigen, natürlich angepasst an das Tempo der synchronisierten Erzählung in diesen Sprachen. Das visuelle Storytelling bleibt konsistent und berücksichtigt gleichzeitig sprachliche Unterschiede. Für Stimmkonsistenz ermöglicht Agent Opus die Verwendung derselben geklonten Stimme über alle Sprachversionen hinweg oder die Auswahl von KI-Stimmen, die in Ton und Energieniveau übereinstimmen. Wenn Ihre Markenstimme auf Englisch warm und freundlich ist, können Sie sicherstellen, dass die japanischen und portugiesischen synchronisierten Versionen dieselbe Wärme durch Stimmauswahl und Sprechstil-Einstellungen vermitteln. Die Plattform behält auch eine konsistente Botschaftshierarchie über Sprachen hinweg bei. Ihre wichtigsten Wertversprechen, Handlungsaufforderungen und Markenversprechen erscheinen in denselben visuellen und zeitlichen Positionen über alle synchronisierten Versionen hinweg. Dies schafft ein kohärentes Markenerlebnis, unabhängig davon, welche Sprachversion ein Zuschauer sieht. Für Teams, die mehrsprachige Inhalte verwalten, bietet Agent Opus Vorlagen und Stil-Presets, die Ihre Markenrichtlinien festlegen. Sobald Sie Ihren visuellen Stil, Ihre Stimmeinstellungen und Tempo-Präferenzen definiert haben, folgt jedes synchronisierte Video, das Sie generieren, automatisch diesen Regeln. Dies eliminiert die Inkonsistenz, die oft entsteht, wenn verschiedene Übersetzer, Synchronsprecher und Editoren an separaten Sprachversionen ohne enge Koordination arbeiten. Das Ergebnis ist eine Bibliothek synchronisierter Videos, die sich anfühlen, als kämen sie vom selben Kreativteam, obwohl sie automatisch in Minuten generiert wurden, anstatt manuell über Wochen produziert zu werden.

Wie handhabt der KI-Synchronisations-Videoersteller die visuelle Synchronisation, wenn die Länge des synchronisierten Audios über Sprachen hinweg variiert?

Agent Opus verwendet intelligentes Szenen-Pacing und visuelle Zusammenstellung, um synchronisierte Videos natürlich wirken zu lassen, auch wenn die Audiolänge über Sprachen hinweg erheblich variiert. Die KI analysiert den semantischen Inhalt und die emotionalen Höhepunkte Ihres Skripts und erstellt dann visuelle Sequenzen, die sich flexibel an unterschiedliche synchronisierte Audiodauern anpassen, ohne gehetzt oder schleppend zu wirken. Wenn Sie ein synchronisiertes Video generieren, verarbeitet Agent Opus zunächst Ihr Skript in allen Zielsprachen, um die Timing-Unterschiede zu verstehen. Manche Sprachen werden länger sein, andere kürzer. Die KI erstellt dann eine visuelle Struktur mit flexiblen Timing-Zonen. Schlüsselmomente wie Produktenthüllungen, Handlungsaufforderungen oder emotionale Höhepunkte werden an bestimmten Punkten in der Erzählung fixiert, während Übergangsszenen und unterstützende Visuals sich ausdehnen oder zusammenziehen können, um der synchronisierten Audiolänge in jeder Sprache zu entsprechen. Wenn Ihr englisches Skript beispielsweise 45 Sekunden dauert und die deutsche synchronisierte Version aufgrund der Sprachstruktur 52 Sekunden dauert, verlangsamt Agent Opus nicht einfach das gesamte Video. Stattdessen identifiziert es Szenen, die natürlich länger gehalten werden können – wie Produktaufnahmen, Lifestyle-Footage oder Motion-Graphics-Sequenzen – und verlängert diese um einige Frames oder Sekunden. Das Tempo fühlt sich beabsichtigt an, nicht gestreckt. Ebenso, wenn die japanische synchronisierte Version nur 38 Sekunden dauert, strafft die KI Übergänge und reduziert Haltezeiten bei nicht-kritischen Visuals, um Energie zu erhalten, ohne hektisch zu wirken. Die Plattform verwendet auch visuelle Techniken, um Timing-Unterschiede zu kaschieren. Dynamische Motion Graphics, geschichtete Animationen und Szenenübergänge erzeugen visuelles Interesse, das leichte Tempo-Variationen für Zuschauer unmerklich macht. Ein Zuschauer, der die spanische synchronisierte Version sieht, hat keine Ahnung, dass die englische Version sieben Sekunden kürzer ist, weil das visuelle Storytelling in beiden vollständig und zielgerichtet wirkt. Für Videos mit KI-Avataren synchronisiert Agent Opus Lippenbewegungen und Gesten mit dem synchronisierten Audio in jeder Sprache. Der Avatar scheint natürlich auf Deutsch, Französisch oder Mandarin zu sprechen, mit Mundformen und Timing, die den phonetischen Mustern jeder Sprache entsprechen. Dies ist keine einfache Überlagerung – die KI generiert sprachspezifische Avatar-Performances, die authentisch aussehen. Das System berücksichtigt auch kulturelle Tempo-Präferenzen. Manche Kulturen bevorzugen schnellere, energischere Präsentation, während andere langsameres, nachdenklicheres Tempo bevorzugen. Agent Opus kann den visuellen Rhythmus an diese Präferenzen anpassen und dabei Ihre Kernbotschaft und Markenidentität über alle synchronisierten Versionen hinweg konsistent halten.