KI-Lippensynchronisations-Videogenerator

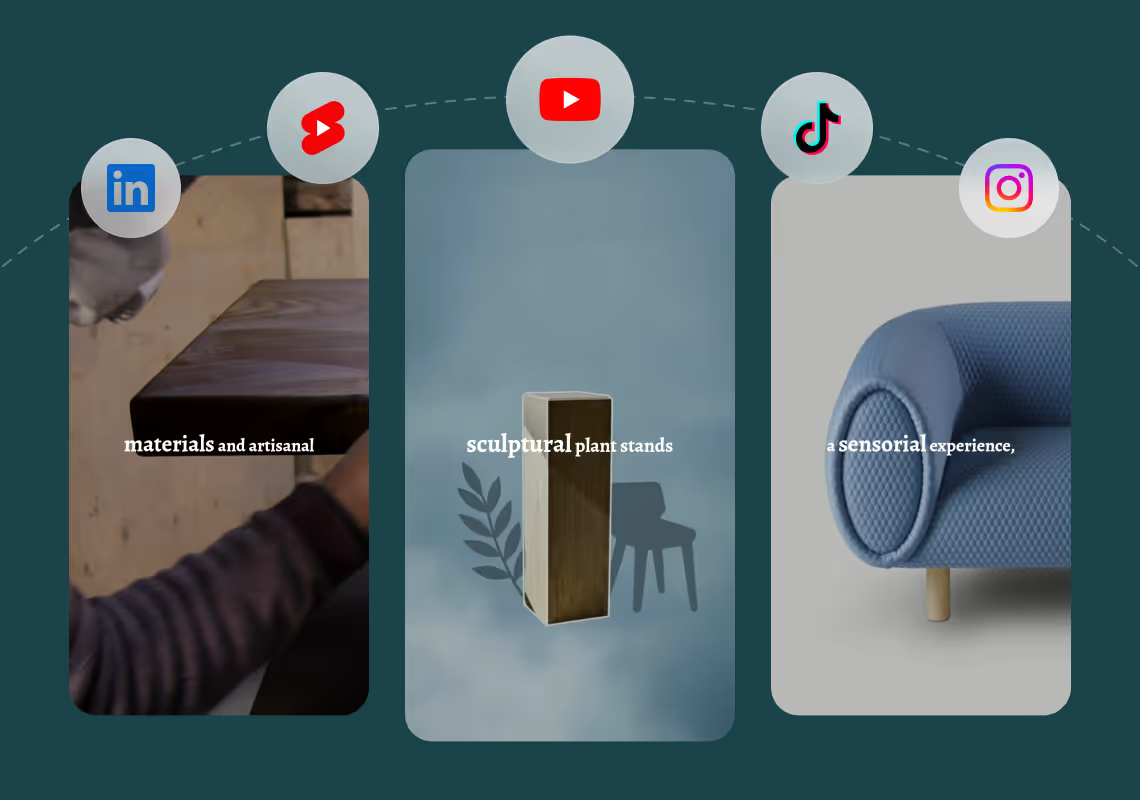

Agent Opus erstellt KI-Lippensynchronisationsvideos aus jeder Texteingabe. Beschreiben Sie Ihre Botschaft, fügen Sie ein Skript ein oder laden Sie eine Blog-URL hoch und erhalten Sie ein fertiges Talking-Head-Video mit synchronisierten Mundbewegungen, Stimme und Bewegungsgrafiken. Keine manuelle Synchronisation, keine Bearbeitungs-Timeline, keine Rendering-Verzögerungen. Ihr KI-Avatar oder Ihre geklonte Stimme spricht Ihre Worte mit perfekter Lippenausrichtung, bereit zur Veröffentlichung auf TikTok, Instagram Reels, YouTube Shorts oder LinkedIn. Ein Prompt liefert ein vollständiges Video.

Explore what's possible with Agent Opus

Reasons why creators love Agent Opus' KI-Lippensynchronisations-Videogenerator

Repurpose Content Instantly

Turn one recording into multiple versions for different platforms, audiences, or campaigns without starting from scratch.

Scale Without Burnout

Create dozens of personalized videos in the time it used to take for one, freeing you to focus on strategy and growth.

Perfect Sync Every Time

Never worry about mismatched audio again—your lips move naturally with every word, accent, and pause.

Scale Content Effortlessly

Create dozens of personalized video variations from one recording, each perfectly lip-synced to different scripts.

Fix Mistakes in Seconds

Update dialogue or correct errors without re-recording footage, saving hours of production time.

Launch-Ready in Minutes

Skip studio costs and lengthy editing sessions while delivering perfectly synced videos that look professionally produced.

How to use Agent Opus’ KI-Lippensynchronisations-Videogenerator

1

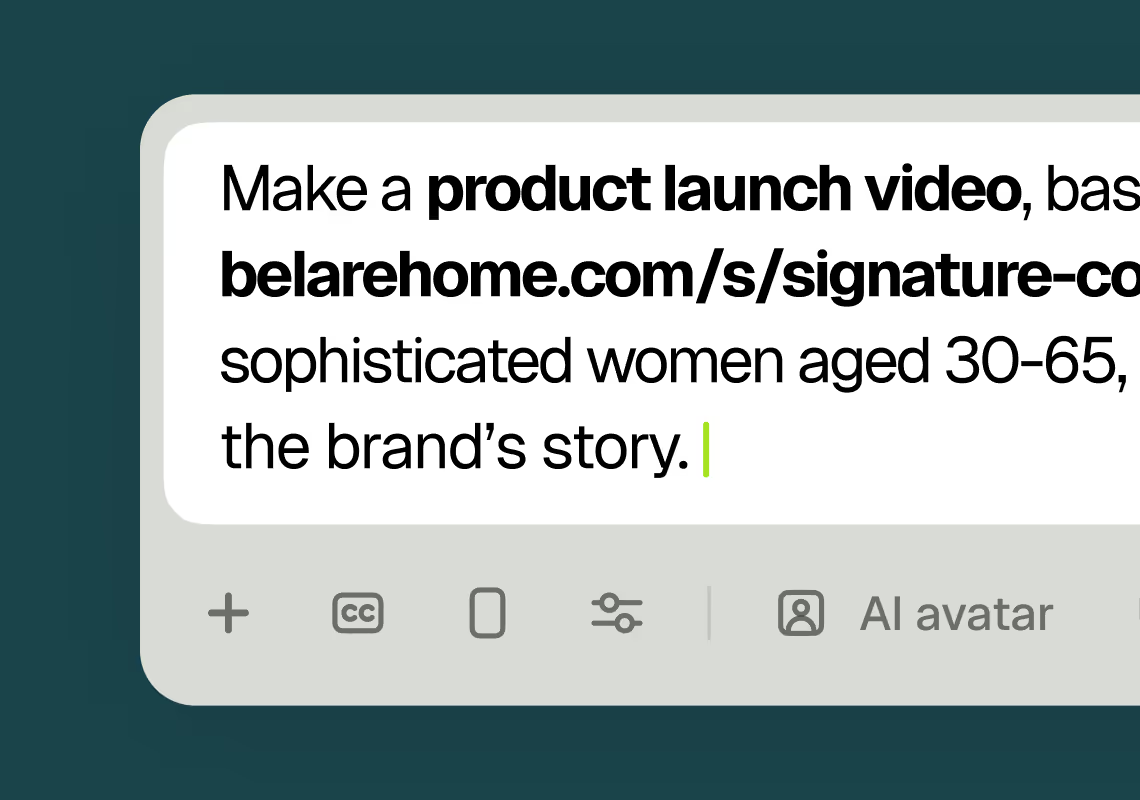

1Describe your video

Paste your promo brief, script, outline, or blog URL into Agent Opus.

2

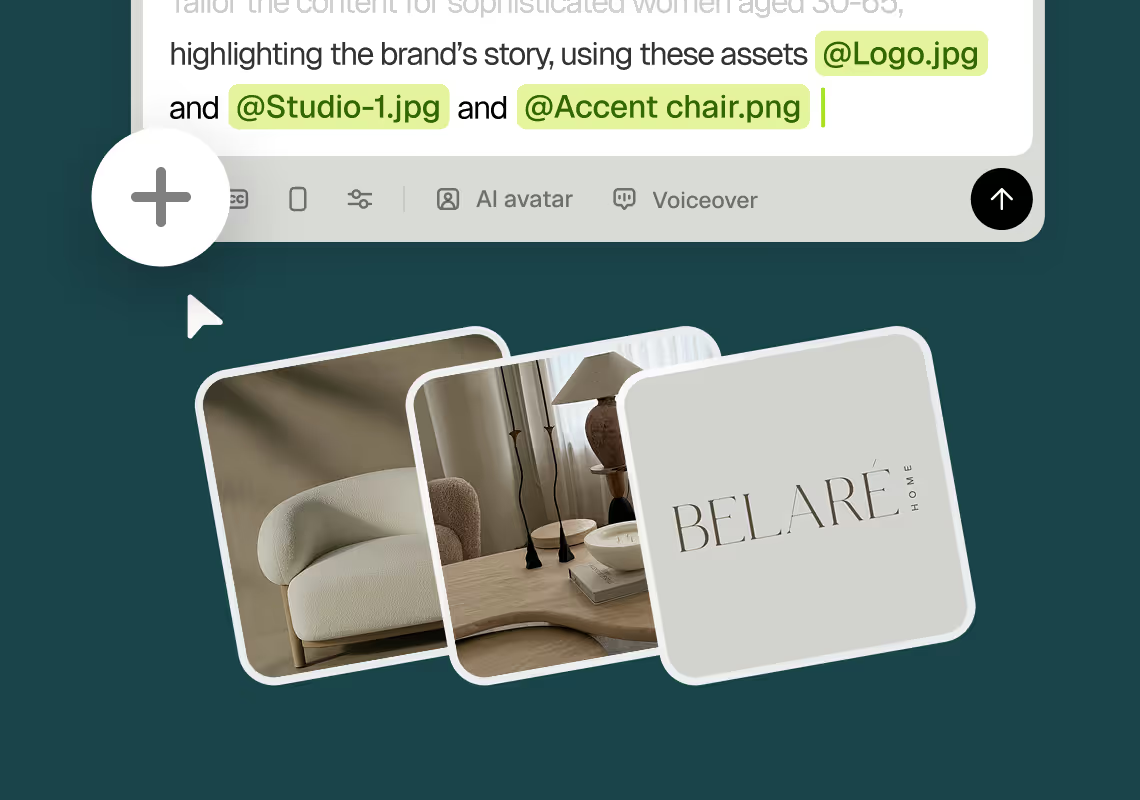

2Add assets and sources

Upload brand assets like logos and product images, or let the AI source stock visuals automatically.

3

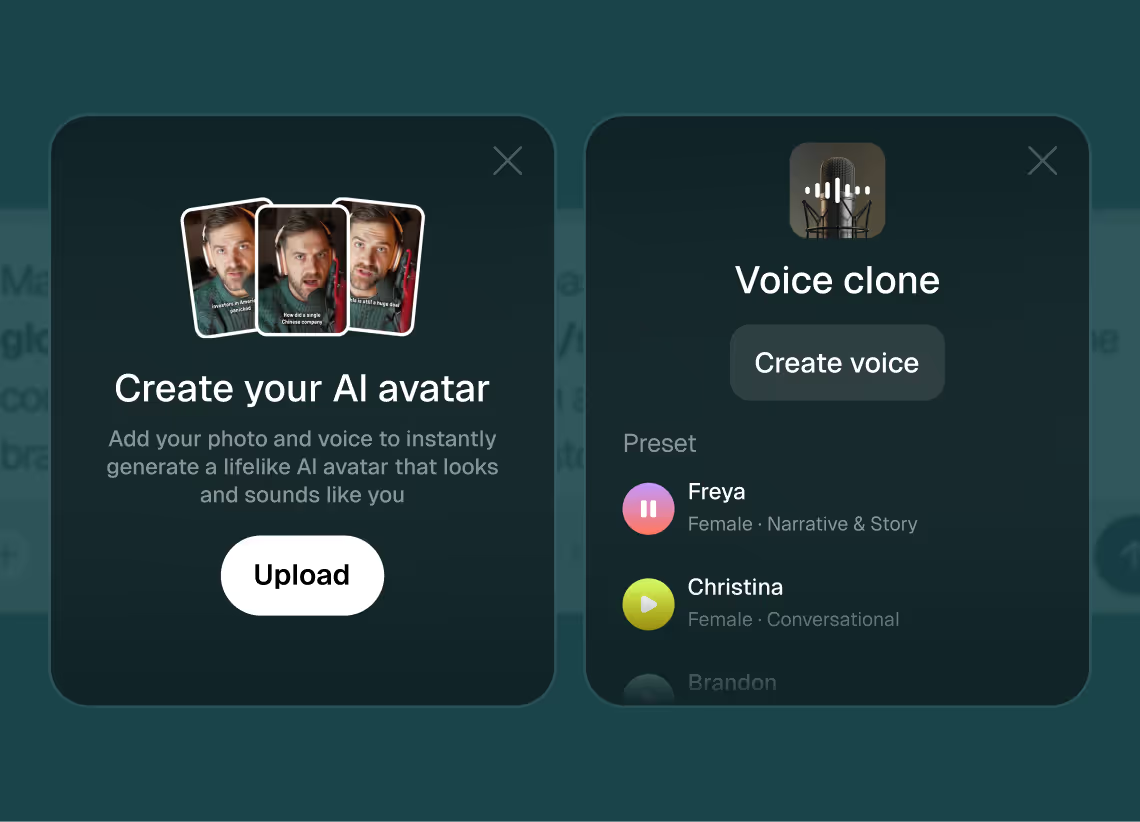

3Choose voice and avatar

Choose voice (clone yours or pick an AI voice) and avatar style (user or AI).

4

4Generate and publish-ready

Click generate and download your finished promo video in seconds, ready to publish across all platforms.

8 powerful features of Agent Opus' KI-Lippensynchronisations-Videogenerator

Custom Voice Integration

Upload your own audio and watch AI avatars lip sync perfectly to your narration.

Multi-Language Sync

Create lip-synced videos in dozens of languages with accurate phoneme matching.

Realistic Lip Sync

Generate videos where avatar mouths move naturally in sync with your audio script.

Brand-Consistent Avatars

Choose or customize avatars that lip sync on-brand messaging across all your videos.

Testimonials

Awesome output, Most of my students and followers could not catch that it was using Agent Opus. Thank you Opus.

Wealth with Gaurav

This looks like a game-changer for us. We're building narrative-driven, visually layered content — and the ability to maintain character and motion consistency across episodes would be huge. If Agent Opus can sync branded motion graphics, tone, and avatar style seamlessly, it could easily become part of our production stack for short-form explainers and long-form investigative visuals.

srtaduck

I reviewed version a and I was very impressed with this version, it did very well in almost all aspects that users need, you would only have to make very small changes and maybe replace one of 2 of the pictures, but even saying that it could be used as is and still receive decent views or even chances at going viral depending on the story or the content the user chooses.

Jeremy

all in all LOVE THIS agent. I'm curious to see how I can push it (within reason) Just need to learn to get the consistency right with my prompts

Rebecca

Frequently Asked Questions

Wie handhabt KI-Lippensynchronisationsvideo verschiedene Stimmstile und Akzente?

Agent Opus analysiert die phonetische Struktur Ihres Audios unabhängig von Akzent, Sprechgeschwindigkeit oder Stimmtonlage. Wenn Sie Ihre Stimme klonen oder eine KI-Stimme auswählen, ordnet das System jedes Phonem (die kleinste Einheit eines Sprachlauts) einer entsprechenden Mundform oder einem Visem zu. Diese Phonem-zu-Visem-Zuordnung funktioniert über Sprachen und Akzente hinweg, da sie auf der Klang-Ebene und nicht auf der Wort-Ebene arbeitet. Wenn Sie mit einem regionalen Akzent sprechen, erkennt die KI die tatsächlichen Laute, die Sie produzieren, und synchronisiert den Mund des Avatars so, dass er genau diesen Aussprachen entspricht. Bei schnellen Sprechern passt das System das Timing jeder Mundform an, um mit schnellen Silben Schritt zu halten. Bei langsamer, bewusster Aussprache verlängert es die Dauer jedes Visems, sodass die Lippen niemals hinter dem Audio zurückbleiben oder vorauseilen. Das Ergebnis ist eine natürliche Lippensynchronisation, die Ihre einzigartigen stimmlichen Eigenschaften respektiert. Sie können dies testen, indem Sie Videos mit verschiedenen Stimmklonen oder KI-Stimmen generieren und die Mundbewegung vergleichen. Jede wird genau synchronisiert, da die zugrunde liegende Phonemanalyse sich an die Audioeingabe anpasst, nicht an eine generische Vorlage.

Was sind Best Practices für das Schreiben von Skripten, die das natürlichste KI-Lippensynchronisationsvideo erzeugen?

Natürliche Lippensynchronisation beginnt mit gesprächsartigen Skripten, die widerspiegeln, wie Menschen tatsächlich sprechen. Vermeiden Sie lange, komplexe Sätze mit mehreren Nebensätzen, da diese den Avatar zwingen, Mundformen über längere Zeiträume ohne natürliche Pausen zu halten. Schreiben Sie stattdessen kurze Sätze mit klarer Subjekt-Verb-Objekt-Struktur. Verwenden Sie Kontraktionen wie „du bist

Kann KI-Lippensynchronisationsvideo konsistentes Branding über mehrere Videos mit unterschiedlichen Skripten aufrechterhalten?

Ja, Agent Opus ermöglicht es Ihnen, Marken-Assets wie Logos, Produktbilder und Farbpaletten hochzuladen, die über alle Ihre KI-Lippensynchronisationsvideo-Projekte hinweg bestehen bleiben. Wenn Sie ein neues Video generieren, greift das System auf Ihre Asset-Bibliothek zu, um den Avatar mit konsistenten visuellen Elementen zu rahmen. Sie können beispielsweise eine Standard-Lower-Third-Grafik mit Ihrem Logo und Slogan festlegen, die in jedem Video erscheint, oder eine Hintergrundvorlage definieren, die Ihre Markenfarben und Produktaufnahmen verwendet. Der Avatar selbst kann ebenfalls konsistent sein. Wenn Sie ein Foto von sich selbst oder einem Teammitglied hochladen, generiert Agent Opus eine digitale Version dieses Gesichts und verwendet es für jedes Video, das Sie erstellen. Kombinieren Sie dies mit einer geklonten Stimme, und jedes Video zeigt denselben Sprecher mit derselben visuellen und stimmlichen Identität. Diese Konsistenz ist wichtig für den Aufbau von Publikumserkennung. Zuschauer sehen dasselbe Gesicht und hören dieselbe Stimme über Ihre TikTok-, LinkedIn- und YouTube-Inhalte hinweg, was Ihre Marke verstärkt, selbst wenn sich das Skript ändert. Sie können auch mehrere Avatar-Stimm-Paarungen für verschiedene Inhaltstypen erstellen. Verwenden Sie beispielsweise einen Avatar für Produktdemos und einen anderen für Kundenstimmen, jeweils mit eigener geklonter Stimme und Hintergrundvorlage. Agent Opus speichert diese Konfigurationen, sodass Sie zwischen ihnen wechseln können, ohne Assets erneut hochzuladen oder Einstellungen anzupassen.

Was sind die Einschränkungen oder Sonderfälle der KI-Lippensynchronisationsvideo-Generierung?

KI-Lippensynchronisationsvideo funktioniert am besten mit klarer, gesprächsartiger Sprache in weit verbreiteten Sprachen. Sonderfälle umfassen Skripte mit starken Hintergrundgeräuschen im Stimmklon, extreme Stimmeffekte wie Flüstern oder Schreien oder Sprachen mit Phonem-Sätzen, die in den Trainingsdaten nicht gut repräsentiert sind. Wenn Sie Ihre Stimme aus einer Aufnahme mit Musik oder Umgebungsgeräuschen klonen, kann die KI Schwierigkeiten haben, die Sprach-Phoneme zu isolieren, was zu weniger präziser Lippensynchronisation führt. Um dies zu vermeiden, nehmen Sie Ihren Stimmklon in einer ruhigen Umgebung mit einem anständigen Mikrofon auf. Extreme Stimmstile stellen das System ebenfalls vor Herausforderungen. Flüstern reduziert die akustische Energie bestimmter Phoneme, was es für die KI schwieriger macht, Mundform-Übergänge zu erkennen. Schreien oder Singen führt Tonhöhenvariationen ein, die die Phonem-zu-Visem-Zuordnung verwirren können. Für beste Ergebnisse verwenden Sie eine natürliche Sprechstimme bei moderater Lautstärke. Ein weiterer Sonderfall ist schneller Code-Wechsel zwischen Sprachen innerhalb eines einzelnen Skripts. Wenn Ihr Skript mitten im Satz zwischen Deutsch und Englisch wechselt, kann die KI Mundformen möglicherweise nicht reibungslos überleiten, da jede Sprache unterschiedliche Phonem-Regeln hat. Bleiben Sie bei einer Sprache pro Video oder trennen Sie mehrsprachige Inhalte in separate Clips. Schließlich können sehr lange Skripte (über 10 Minuten Sprache) Videos erzeugen, bei denen der Gesichtsausdruck des Avatars im Laufe der Zeit statisch wird. Agent Opus generiert Mikro-Ausdrücke und Kopfbewegungen, um den Avatar lebendig zu halten, aber ausgedehnte Monologe können sich weniger dynamisch anfühlen als kürzere, prägnantere Videos. Teilen Sie lange Inhalte in mehrere Videos auf, um visuelles Interesse aufrechtzuerhalten und der KI mehr Möglichkeiten zu geben, die Leistung des Avatars zu variieren.